🗣️Word Embeddingとは?自然言語処理で重要な技術を解説🤖

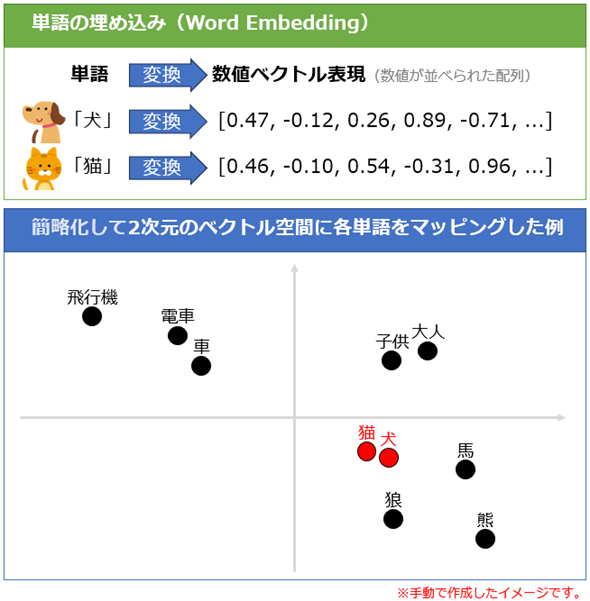

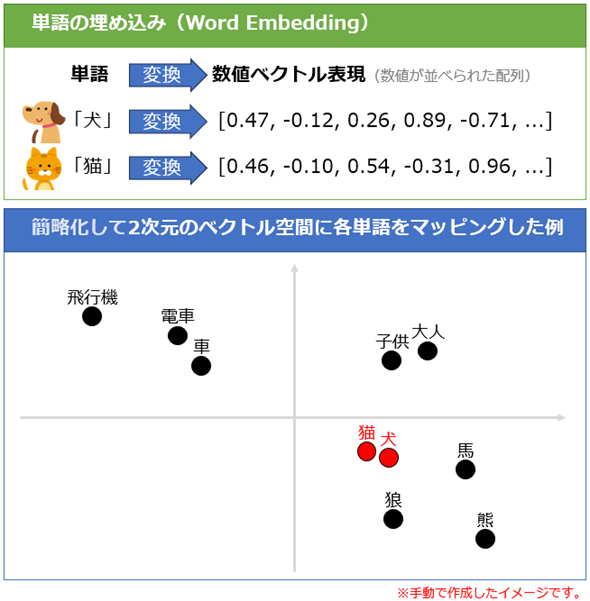

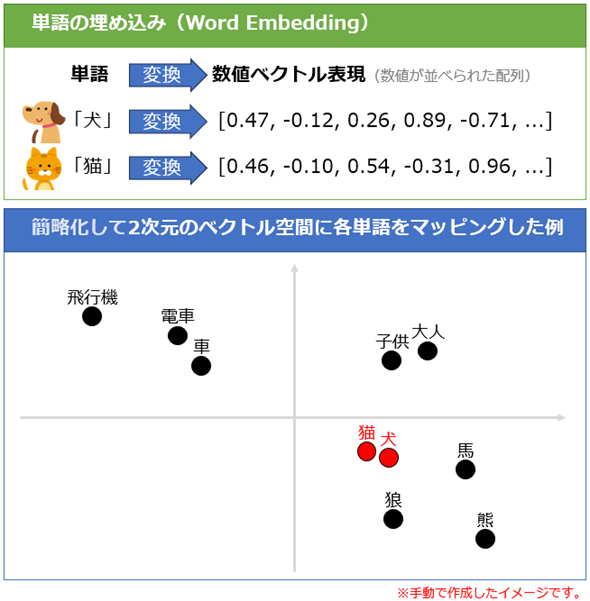

Word Embeddingとは、自然言語処理における重要な技術の一つであり、コンピュータが人間の言語を理解することを助ける数学的表現です。この技術は、単語やフレーズをベクトル空間上の点として表現し、それらの意味的な関係性を数値的に捉えることができます。Word Embeddingにより、コンピュータは単語の類似性や文脈による意味の変化を理解し、より正確な自然言語処理が可能となります。本記事では、Word Embeddingの基本概念からその応用方法まで、自然言語処理においてどのように活用されているのかを詳しく解説します。

🗣️Word Embeddingとは?自然言語処理で重要な技術を解説🤖

Word Embeddingは、自然言語処理における重要な技術です。これは、単語をベクトル空間上の点として表現する技術で、単語の意味や類似性を数値的に扱うことができます。Word Embeddingを活用することで、文章の意味をより正確に捉えることができるようになります。

Word Embeddingの働き

Word Embeddingは、単語をベクトルとして表現することで、単語同士の関連性や類似性を捉えることができます。例えば、「dog」と「cat」はどちらも動物であり、似た意味を持つため、ベクトル空間上で近い位置に配置されます。一方、「dog」と「umbrella」は意味的に関連性が低いため、ベクトル空間上で離れた位置に配置されます。

| 単語 | ベクトル表現 |

|---|---|

| dog | [0.2, 0.9, 0.1] |

| cat | [0.3, 0.8, 0.2] |

| umbrella | [0.8, 0.1, 0.6] |

Word Embeddingの種類

Word Embeddingにはいくつかの種類がありますが、主なものにはWord2VecとGloVeがあります。Word2Vecは、大量のテキストデータから単語の出現頻度を元にベクトルを学習します。一方、GloVeは、単語の共起頻度を利用してベクトルを学習します。

📱iPhoneでWordを使う!アプリのインストールと使い方📲Word Embeddingの利点

Word Embeddingを用いることで、単語の意味や類似性を数値的に扱うことができるようになります。これにより、自然言語処理タスクでの精度向上が期待できます。また、単語のベクトル表現を用いることで、単語の意味的な操作も可能となります。例えば、「king」から「man」を引いて、「woman」を足すことで「queen」というような結果が得られます。

| 単語 | ベクトル表現 |

|---|---|

| king | [0.5, 0.2, 0.7] |

| man | [0.6, 0.1, 0.8] |

| woman | [0.4, 0.3, 0.6] |

| queen | [0.3, 0.4, 0.5] |

Word Embeddingの用途

Word Embeddingは、自然言語処理のさまざまなタスクに適用されています。例えば、感情分析、文章分類、機械翻訳、質問応答システムなどで活用されています。これらのタスクでの精度向上に寄与しています。

Word Embeddingの今後の展望

Word Embeddingは、自然言語処理の分野で重要な技術として注目されています。今後も、より精度の高いWord Embeddingの開発や、さまざまな自然言語処理タスクへの適用が期待されています。また、深層学習との組み合わせにより、より複雑な自然言語処理タスクにも対応できるようになるでしょう。

Word Embeddingとはどういう意味ですか?

Word Embeddingとは、単語を固定された次元のベクトル空間上の点として表現する手法です。単語の意味や文脈を数値として捉えることができるため、自然言語処理における重要な技術となっています。Word Embeddingにより、単語間の類似性や関連性を計算することが可能になり、意味的な情報を数値化してコンピュータが理解できる形으로変換することができます。

Word Embeddingの種類

Word Embeddingにはいくつかの種類があります。以下に主なものを挙げます。

- Word2Vec: 単語の周囲にある単語を予測することで、単語の意味を捉える手法です。

- GloVe: グローバルな単語の共起行列を用いて単語の意味を捉える手法です。

- FastText: 単語をサブワードに分解し、サブワードのベクトルを用いて単語の意味を捉える手法です。

Word Embeddingの利点

Word Embeddingには以下のような利点があります。

- 単語の意味の捉え方: 単語の意味を数値として表現できるため、コンピュータが単語の意味を理解しやすくなります。

- 単語間の関係性の計算: 単語間の類似性や関連性を計算できるため、意味的な情報を利用した自然言語処理が可能になります。

- 次元削減: 単語を固定された次元のベクトルとして表現することで、次元の呪いの問題を回避できます。

Word Embeddingの応用例

Word Embeddingは自然言語処理のさまざまな分野で応用されています。以下に主な応用例を挙げます。

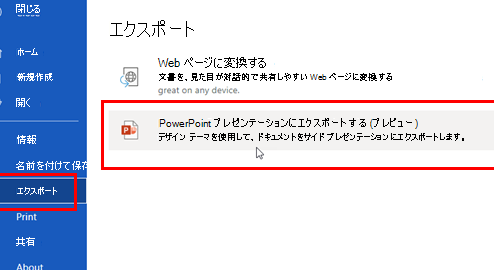

🔄WordをPowerPointに変換!プレゼン資料を簡単に作成📊- 感情分析: 文章の感情を正確に予測するために、単語の意味情報を利用します。

- 機械翻訳: 単語の意味を正確に捉えることで、より自然な翻訳結果を得ることができます。

- 文書分類: 文章の意味情報を利用して、文章を適切なカテゴリに分類します。

機械学習におけるEmbeddingとは?

機械学習におけるEmbeddingとは、データを数値的な表現に変換するプロセスであり、特に高次元のデータを低次元の密なベクトル空間にマッピングすることを指します。Embeddingは、単語、画像、音声などのデータをコンピュータが理解できる形式に変換し、ニューラルネットワークなどの機械学習モデルで処理できるようにします。

1. 単語のEmbedding

単語のEmbeddingは、自然言語処理において、単語やフレーズを密なベクトル表現に変換する技術です。各単語は、ベクトル空間内の特定の位置にマッピングされ、その位置関係から単語間の意味的な関連性や類似性を捉えることができます。単語のEmbeddingの代表的な手法には、以下のようなものがあります。

- Word2Vec: 単語の共起情報を利用して、単語を密なベクトル表現に変換する。

- GloVe: グローバルな単語の共起行列を用いて、単語のベクトル表現を学習する。

- FastText: 単語をサブワードに分解し、サブワードレベルの情報を利用して単語のベクトル表現を学習する。

2. 画像のEmbedding

画像のEmbeddingは、画像を低次元のベクトル表現に変換する技術です。画像のEmbeddingは、畳み込みニューラルネットワーク(CNN)を用いて画像の特徴を抽出し、密なベクトル表現に変換します。画像のEmbeddingを用いることで、以下のような応用が可能になります。

🔗WordでURLを青くしない方法!リンクの色を変更する方法🎨- 画像分類: 画像のEmbeddingを用いて、画像が属するクラスを予測する。

- 画像検索: 画像のEmbeddingを用いて、類似する画像を検索する。

- 画像キャプショニング: 画像のEmbeddingを用いて、画像の内容を自然言語で説明するキャプションを生成する。

3. グラフのEmbedding

グラフのEmbeddingは、グラフ構造を低次元のベクトル表現に変換する技術です。グラフのEmbeddingは、グラフニューラルネットワーク(GNN)を用いてグラフのノードやエッジの特徴を抽出し、密なベクトル表現に変換します。グラフのEmbeddingを用いることで、以下のような応用が可能になります。

- ノード分類: グラフのノードのEmbeddingを用いて、ノードが属するクラスを予測する。

- リンク予測: グラフのノードのEmbeddingを用いて、ノード間にリンクが存在するかどうかを予測する。

- グラフ分類: グラフ全体のEmbeddingを用いて、グラフが属するクラスを予測する。

Word Embeddingの欠点は何ですか?

Word Embeddingは、単語をベクトル空間上に埋め込むことで、単語の意味を数値的に表現する手法です。しかし、この手法にもいくつかの欠点が存在します。

意味の埋め込みの不完全性

Word Embeddingは、単語の意味を完全に捉えることができない場合があります。例えば、多義語やひらがなやカタカナのみで表現された単語に対して、適切な意味の埋め込みが難しいことがあります。また、文脈によって意味が変わる単語にも対応しきれないことがあります。

📄WordでPDFを開く方法!PDFファイルをWordで編集する方法📝- 多義語の扱い

- ひらがなやカタカナのみの単語の埋め込み

- 文脈による意味の変化

計算コストの問題

Word Embeddingを学習するには、大規模なコーパスが必要であり、学習に要する計算コストが高いです。また、学習済みのモデルを適用する際にも、メモリや計算資源を大量に消費することがあります。

- 大規模なコーパスの必要性

- 学習時の計算コスト

- 適用時のリソース消費

バイアスの問題

Word Embeddingは、学習に用いたコーパスに含まれる偏りを学習してしまうことがあります。これにより、性別や人種などのバイアスが埋め込みベクトルに反映されることがあります。このようなバイアスは、実際の応用において問題となることがあります。

- コーパスに含まれる偏りの学習

- 性別や人種などのバイアスの反映

- 応用における問題

Embeddingモデルとは何ですか?

Embeddingモデルとは、何らかの特徴空間へと入力を写像するニューラルネットワークのことです。このモデルは、言葉や画像などを数値的な特徴量に変換し、コンピュータが理解できる形にすることができます。特に、自然言語処理においては、単語や文章をベクトル空間に写像することで、その意味や文脈を捉えることができます。

単語の Embedding

単語の Embedding とは、単語をベクトル空間に写像することで、単語の意味や文脈を捉える技術です。例えば、Word2VecやGloVeなどの手法があります。これらの手法では、単語の意味の類似性がベクトルの距離や方向で表現されます。たとえば、「cat」と「dog」のベクトルは近く、「cat」と「computer」のベクトルは遠くなるでしょう。

- Word2Vec: 大量のテキストデータから単語の共起関係を学習し、単語をベクトル化します。

- GloVe: グローバルな単語の共起行列から単語のベクトルを学習します。

- FastText: 単語をサブワードに分解し、サブワードレベルでベクトルを学習します。

文章の Embedding

文章の Embedding は、文章全体をベクトル空間に写像する技術です。単語の Embedding と比較して、文章の意味やニュアンスを捉えることができます。例えば、BERTやDoc2Vecなどの手法があります。これらの手法は、文章の構造や単語の並び順を考慮し、文章のベクトルを生成します。

- BERT: 大量のテキストデータから文章の文脈情報を学習し、文章をベクトル化します。

- Doc2Vec: Word2Vecの拡張版で、文章のIDを用いて文章ベクトルを学習します。

- Universal Sentence Encoder: 異なるタスク間で転移学習が可能な文章のベクトルを生成します。

画像の Embedding

画像の Embedding は、画像をベクトル空間に写像することで、画像の内容や特徴を捉える技術です。例えば、ResNetやVGGNetなどの畳み込みニューラルネットワーク(CNN)がこの目的で使用されます。これらのネットワークは、画像の特徴を階層的に抽出することで、最終的に画像をベクトル化します。

- ResNet: 残差ブロックを用いて、深いネットワークの学習を可能にします。

- VGGNet: 少ないパラメータ数で高い性能を発揮するCNNモデルです。

- InceptionNet: 異なるサイズのフィルタを用いて、複数スケールの特徴を抽出します。

よくある質問

Word Embeddingとは何ですか?

Word Embeddingは、自然言語処理において、単語を数値のベクトルに変換する技術です。各単語は、密接に関連する単語と類似したベクトルを持ち、関連性が低い単語とは異なるベクトルを持ちます。これにより、コンピュータは単語の意味や関連性を理解し、より正確な自然言語処理が可能になります。

Word Embeddingの主な手法にはどのようなものがありますか?

Word Embeddingの主な手法には、Word2Vec、GloVe、FastTextなどがあります。Word2Vecは、単語の周囲に出現する単語からその単語の意味を推定します。GloVeは、全体的な単語の共起行列から単語の意味を捉えます。FastTextは、単語を更に細かい単位(文字nグラム)まで分解し、より詳細な意味を捉えることができます。

Word Embeddingはどのように使用されますか?

Word Embeddingは、自然言語処理のさまざまなタスクで使用されます。例えば、感情分析では、単語のベクトルを用いてその感情を推定します。機械翻訳では、単語の意味を正確に捉えることで、より自然な翻訳が可能になります。また、文書分類や質問応答システムなど、多くのアプリケーションで活用されています。

Word Embeddingの利点は何ですか?

Word Embeddingの最大の利点は、単語の意味を数値で表現できることです。これにより、コンピュータは単語の意味を理解し、より正確な自然言語処理が可能になります。また、単語間の関連性を捉えることができるため、類推のような高次の言語処理も可能になります。さらに、大規模なデータセットから学習することで、未知の単語や言い回しにも対応できる柔軟性があります。